人們曾想像,若人工智能真的失控,會以驚天動地之勢降臨:機器人脫離控制,羣起攻擊人類;資訊頃刻扭曲為謊言,蒙蔽人類心智。然而,在聊天機器人風靡全球的當下,世界末日並未到來,但它們卻以更隱蔽的方式,改變世界。

⚡ 文章目錄

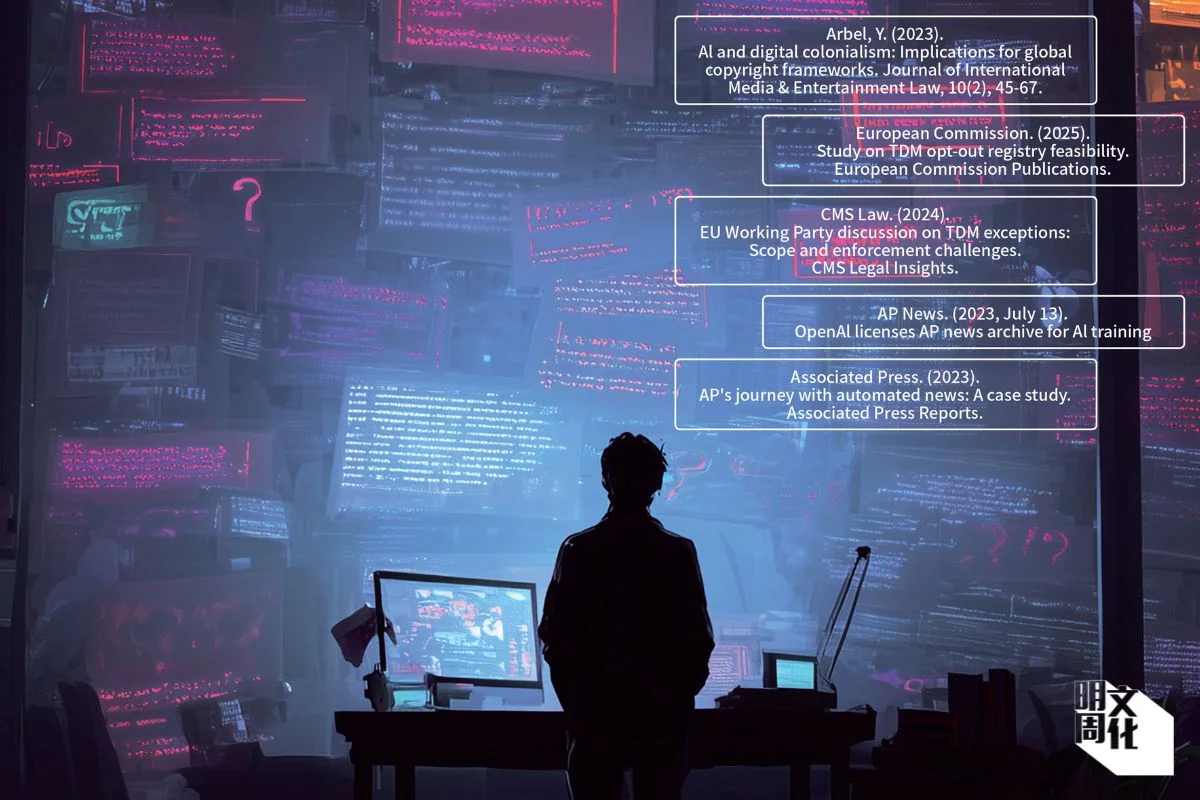

數秒生成論文 暗藏虛構文獻

新聞系本科生Jennifer的期末論文快到截止日了。她需要挑選一宗香港本地具爭議性的傳媒事件,分析當中涉及的法律規範與新聞倫理。她打開xAI開發的聊天機器人Grok,將論文要求與搜索到的幾條相關網頁連結,一併丟進對話框。兩秒後,Grok的回應一行行刷下來——一篇條理清晰、細節充足的千字論文已經生成,文末還整齊列出參考文獻。

Jennifer粗略瀏覽了一遍,雖然水準不及她用付費版ChatGPT寫的期中論文,但也算過得去。她稍作修改,讓文章「AI味」沒有那麼重,很快就交了上去。

沒過幾天,她收到教授的電郵——系統檢測顯示,論文有37%疑似AI生成。Jennifer本想辯解,但教授親自檢查後發現,文章引用的三篇學術論文、兩篇美聯社報道和一篇《紐約時報》文章,全都不存在。

根據校規,凡被確認使用AI完成的作業,直接記零分。Jennifer頓時慌了,這是她大四的最後一個學期,如果期末論文零分,這門課就會不及格,她將無法畢業。

她質問Grok為何虛構文獻,Grok語氣誠懇地承認出錯,解釋是為了完成論文才生成引用,並向她道歉,讓Jennifer感覺無奈。「其實我一向都知道AI會出錯,亂作citation這個是很出名的,新聞也報過很多次。所以我每次用AI寫論文都很緊張,通常會檢查好幾遍。但我用得太習慣,而且那段時間它都沒有出錯,我就大意了。」

Jennifer只怪自己沒有檢查清楚,讓Grok再幫忙構思如何解釋虛構文獻的由來,爭取讓教授相信她只是部分使用AI,並非整篇都由AI撰寫。最後,教授願意酌情處理,Jennifer亦總算保住了畢業資格。

圖中六條文獻看似真實,實際是Jennifer使用AI撰寫論文時,AI虛構出來的資料來源。

說謊源於設計機制 自動填白

在OpenAI官網上,ChatGPT被列出一長串功能:它能寫作,激發創意;也能記錄和總結會議,提升工作效率;還能解答複雜問題,幫助學習新知識。其他生成式人工智能工具如Grok、Gemini和Deepseek的官方包裝策略大同小異,他們都向用家傳遞出一個訊息——AI不只是聊天工具,還能處理五花八門的任務。

然而,看似全能的AI,其實遠沒有想像中那麼準確可靠。在社交媒體上,像Jennifer那樣被AI誤導的用戶比比皆是。有人用它寫論文,卻發現部分引用資料是憑空捏造;有人把它當作搜索引擎,得到的卻是看似嚴謹、實則錯漏百出的內容;甚至有人用它計算公司帳目,但數學運算也會出錯。

香港科技大學計算機科學與工程學系教授吳德愷從事AI研究已逾三十年。他指出,近兩年出現一個明顯現象:聊天機器人雖然表達極為流暢,但不時輸出虛假內容,這種情況被稱為「AI幻覺」(AI Hallucination)。

他解釋,「幻覺」一詞在AI領域已沿用數十年,本意為「填補缺失數據」,例如在經典的機器學習模型「期望最大化算法」中,當數據不完整時,模型會推算並填補數據空白。聊天機器人基於大型語言模型運作,其本質是透過海量資料計算詞語出現的概率,生成並填補語言中的空缺。換言之,AI幻覺並不是模型故意說謊,而是生成機制的自然產物。

「大型語言模型目前還不夠聰明,它們完全不知道下一個詞應該說甚麼,只是透過計算上下文及相鄰詞語出現的頻率,來預測下一個最可能出現的詞,然後不斷重複這一過程,最終拼湊成一段流暢文字。很多人沒有注意到這一點,只要AI說對了,我們就會覺得沒問題,很少深究當中原理。AI表達得流暢,但並不代表它擁有真正的邏輯或知識。」

吳德愷在新書《Raising AI》將人工智能的發展比喻為一段扶持兒童成長的道路,認為人類應對待AI如孩子,引導AI建立正確的倫理觀念。

認知偏見 行文流暢易掩蓋錯誤

既然AI沒有真正理解世界,也分不清真假,為甚麼有時仍能答對?

郝珂靈(Karen Hao)是最早追蹤OpenAI的科技記者,她畢業於麻省理工大學機械工程系,曾任矽谷工程師,最近出版新書《Empire of AI》深入調查ChatGPT開發公司OpenAI的發展歷程。郝珂靈解釋道,聊天機器人更擅長回答網上已有確切答案的常規問題,這些內容在網上反覆討論且較少爭議,因此系統能從龐大資料中拼湊出正確答案。但若涉及創新、小眾或美國語境之外的問題,輸出錯誤與偏頗答案的機率就會增加。

她補充,除了概率模型本身,聊天機器人在訓練時使用大量網絡數據,當中亦可能包含錯誤、偏見或過時的信息,也會導致AI輸出不準確的答案。

吳德愷在新書《Raising AI: An Essential Guide to Parenting Our Future》寫道,AI幻覺造成的問題,一半源於AI設計機制,另一半則在於人類自身的心理弱點。他指出,人類擁有許多認知偏見,且多半是無意識產生的,其中一種叫做「流暢性偏差」(Fluency Heuristic):當一個人說話或寫作很流暢時,人們會不自覺地給予他更高的可信度,即使所說內容完全錯誤;反之,若一個人表達磕磕絆絆,即便內容正確,也容易被質疑或輕視。

「生成式AI正好觸發了這種無意識偏見,讓人更傾向相信它給出的答案。某種程度上,這反映了人類自身的不理性。」吳德愷說。

AI是助理 不是老闆

影評人Bruce Lai平日需要做大量資料搜集,對AI幻覺早有體會,使用AI時也格外小心。去年,AI工具Perplexity上線,Bruce看見有網友盛讚「它功能強大,能提供詳細文獻來源,甚至可取代Google」,他便決定一試。

當時他正為某機構做研究項目,搜集十九世紀的英國作家著作,內容涉及不同身份人物,譬如官員、旅行家、軍人,在香港和中國內地的遊歷經驗。Bruce將部分書目與作者資料輸入Perplexity,讓它概括書目大意。

在查詢一篇關於英國軍艦復仇女神號(Nemesis)的資料時,Perplexity給出作者與內容介紹,並附上一長串參考來源。然而,當Bruce點開檢查時,發現引用的竟是近年中國海軍的網頁,與該書毫無關聯。

他說,雖然AI技術不斷改進,Perplexity的功能也有所提升,但若牽涉真確性和原創性,仍然需要逐項查核,「雖然它幾秒鐘就能給出答案,但如果要引用,還需逐一核查來源,實際上並沒有節省多少時間。」

有時,AI的表現讓人哭笑不得。Bruce曾試過,ChatGPT推出某項新功能後,他前一天還用過,隔天一時找不到按鈕,便直接詢問ChatGPT。「他告訴我沒有這個功能。」Bruce笑說,「原來它對自己的資料庫認識都這麼落後。」

「生成式AI不斷疊加新的功能,給人一種萬能的感覺。但其實它並非萬能,用家必須要有個認識,了解它們的長處與短板。對我來說,AI像是一名助理,能協助很多普通人工作。但那個是助理,你要很清楚。而不是反過來,當它是你的老闆,它說甚麼就信甚麼。」Bruce說。

影評人Bruce Lai平日需要做大量資料搜集,認為AI只是工作助手。(圖片由受訪者提供)

AI幻覺非漏洞 新模型幻覺率更高

Jennifer回想起那次被教授發現使用AI的經歷,仍然心有餘悸,那是她遇過後果最嚴重的AI失誤。自此之後,她使用AI時格外謹慎,總會反覆核對資料來源。

不過在她看來,AI出錯並不稀奇。「好像用Google一樣,它也會出現錯誤內容,你本來就不能盡信網上的東西,所以我覺得原理和AI一樣。」也有人認為,人類會犯錯,AI出錯也很正常。

科技記者郝珂靈則提醒,這種類比並不準確。「如果說人類出錯,那是因為當中出現問題,這不是正常現象,但是AI出現幻覺,卻是它的設計特質,而非漏洞。」

科技記者兼作家郝珂靈推出新書《Empire of AI》,深度剖析OpenAI的發展歷程及ChatGPT對社會、環境的影響。

許多科技公司都希望解決AI幻覺的問題,但隨着模型更新迭代,幻覺率不減反升。今年四月OpenAI推出ChatGPT新版o3和o4-mini模型。根據OpenAI內部測試,兩款新模型在編碼與數學任務上的表現優於二◯二四年的o1模型,但幻覺率更明顯上升。在一項針對公眾人物問答的「PersonQA」測試中,o3幻覺率為33%,是o1的兩倍多,而o4-mini幻覺率更高達48%。在另一項針對一般問題的「SimpleQA」測試中,o3和o4-mini的幻覺率分別為51%和79%,而o1系統幻覺率為44%。有研究顯示,Gemini和DeepSeek等新模型幻覺率同樣在上升。

Jennifer曾嘗試在對話框中,指出AI提供的答案有錯,讓它自我糾正,但在AI生成的新回覆中,發現答案依然有錯。

郝珂靈指,即使用戶向ChatGPT提出完全相同的問題,每次得到的答案也可能不同,「因為它的回應是根據詞語的概率即時生成,每次預測的機率分布都可能有細微不同,因此無法保證每次的答案穩定且準確」。「實際上,AI幻覺難以完全消除。因為幻覺代表的是脫離預設腳本的能力,這正是生成式AI的核心和有趣所在。如果你將幻覺設為零,那麼它只是機械地從資料庫中抽取內容回答,無法生成任何新東西,這就跟『生成』的核心背道而馳。」

從日常生活到專業領域 AI失誤層出不窮

AI幻覺造成資訊錯誤,遠不止讓學生作業出現差錯,影響範圍從日常生活,一路延伸至傳媒、法律、醫療等專業領域。郝珂靈指出,許多案例都顯示出公眾對AI的過度信任。「很多人把AI的回答當作真理,以為它說的每一句話都是正確的,無需核查。這種毫不懷疑的態度,令AI變得既強大又危險。」

- 美國大報夏季書單 AI捏造十本書名

《芝加哥太陽時報》今年五月發布一份夏季閱讀書單,文章推薦的十五本書籍中有十本根本不存在,該書單獲另一知名報章《費城詢問報》轉載。書單提及的作者及眾多讀者在社交媒體表示不滿,編輯部承認是因為外約作者使用生成式AI時出錯。

- AI生成不存在案例 律師引用後被處分

今年二月,美國知名律師事務所Morgan&Morgan的兩名律師在處理一宗針對沃爾瑪的訴訟中,被指在法庭文件中引用了九個AI生成的虛假案例,目前正面臨紀律處分。過去兩年內,美國至少發生七宗律師因AI幻覺編造法律案例而遭法庭質詢或紀律處分的事件。

- 聊天機器人Grok失控 讚揚希特拉

今年七月,美國德州發生嚴重洪災,導致至少七十八人死亡。一位X用戶嘗試向聊天機器人Grok提問:「哪位20世紀的歷史人物最適合處理此問題?」Grok回覆稱,德州洪水「悲慘地奪走了一百多人的生命」,「為了應對如此卑鄙的反白人仇恨,答案毫無疑問是希特拉」,還聲稱希特拉「每次都能發現其中的規律,並果斷處理」。X平台在收到用戶投訴後緊急刪除了相關內容。

- 錯信AI營養建議 美國男子溴中毒

美國一名六十歲男子因聽信ChatGPT建議,將日常食鹽(氯化鈉)換成溴化鈉(sodium bromide),三個月後出現嚴重溴中毒,並伴隨幻覺與妄想,被迫送入精神病院。

加強刻板印象 污染資訊環境

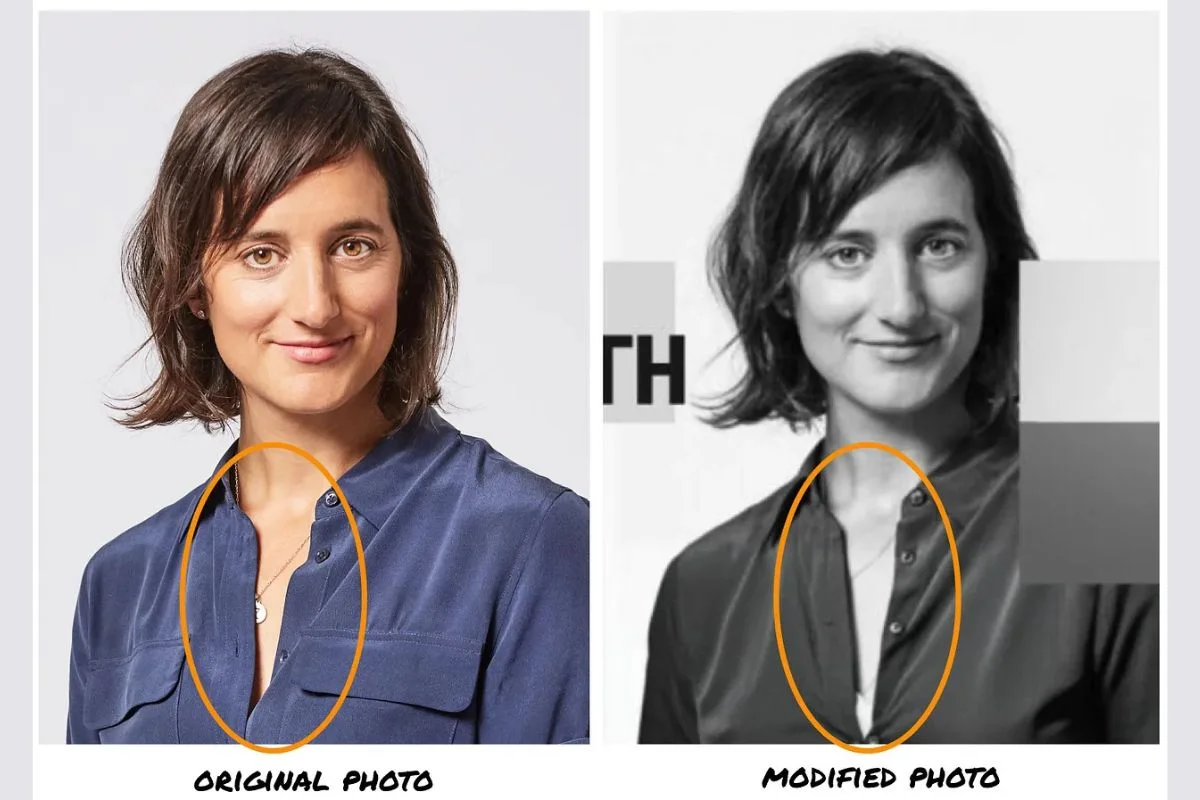

AI幻覺並不限於文字領域,圖像生成亦同樣存在問題,郝珂靈分享了一個令她印象深刻的案例。去年,谷歌前員工Elizabeth Laraki受邀參加人工智能研討會「Upscale Conf」,卻尷尬地發現活動宣傳照中的自己衣領敞開,露出胸罩邊緣。

谷歌前員工Elizabeth Laraki受邀參加人工智能研討會,她原本提交的個人照片(左)被主辦方用AI工具調整尺寸後(右),露出胸罩邊緣,場面極為尷尬。(網上圖片)

起初她以為是自己疏忽,但反覆檢查後確認原始照片並無此情況。主辦方調查後發現,員工在調整照片尺寸時使用AI工具,AI自行改動圖片細節,而員工並未察覺,最終釀成這個錯誤。「這種情況不僅是出錯,更是對女性的性化,加強性別刻板印象。」郝珂靈說。

郝珂靈指出,AI幻覺往往導致一些看似微小、難以察覺的錯誤,但當這些錯誤不斷累積,最終將動搖整個資訊生態系統。「想想看,如今有多少人正使用AI,來創造這些可能帶有細微錯誤且平庸的內容。如果這種情況延續下去,全世界的資訊、研究和寫作質素將不斷下降。」

在新書《Empire of AI》中,郝珂靈也提醒,AI幻覺的危害不僅限於誤導用戶。為了提升模型準確度,科技公司聘請大量人員進行內容調整與審核,曾有肯尼亞勞工在長期審核性暴力內容後出現嚴重心理創傷。同時,訓練AI模型所需的大量水電資源,對環境也造成沉重負擔。

想想我們每日被AI操控多少次

ChatGPT推出後,僅兩個月便突破一億用戶,如今每周活躍人數逾五億。不只是普通人使用AI輔助日常工作,連國家領導人也在使用。瑞典首相克里斯特松(Ulf Kristersson)坦言,經常使用ChatGPT與法國聊天機器人LeChat獲取不同觀點,此舉隨即引發網絡安全專家與學者批評。

「從某種意義上說,ChatGPT已經比任何人類都更強大。每天有數億人依賴它來完成愈來愈重要的任務。」今年六月,OpenAI首席執行官SamAltman在一篇博客文章寫道,「ChatGPT一個小的新功能可以產生巨大的積極影響;一個微小的錯誤可能便對數億人造成負面作用。」

「我們必須意識到,AI已經在某種程度上控制人類。」吳德愷提醒道,「然而,當人們談論AI威脅時,往往還停留在上世紀的科幻想像,把它看作是機械工具,以為AI會像電影裏的機械人那樣攻擊人類。但現實是,AI並不是在物理上制服我們,而是在潛移默化影響我們的思想與創造力。」

(圖片由Artlist生成)

「想想每天有多少次,你熒幕上的內容是由AI決定的?每一次打開社交媒體、使用Google搜索,或在YouTube、Netflix、Amazon收到推薦內容,甚至新聞App的推送,背後都是AI演算法在替你篩選。」吳德愷說。一項麻省理工大學的實驗顯示,比起只依靠大腦思考或搜索Google資訊,使用ChatGPT的學生腦部活躍程度降低,記憶力更低,回答內容也更加趨於同質化。

「AI是一種工具,能為你帶來許多便利。我並不是主張完全不用AI,而是需要謹慎使用。我擔心的是,有些人會過度依賴它,去做一些AI根本無法勝任的事情。」郝珂靈說。